重绘学派法术绪论 V1.X

本文档是基于【腾讯文档】重绘学派法术绪论1.1更改的Invoke版,相比于WebUI,InvokeAI更加的适合专业的AI辅助绘画。本文将会基于InvokeAI V3.7.0的UI界面讲解,是AI辅助绘画的入门级文档。在修习本课程之前,请确保你已经修习过了了提示词基础,或者已经会使用你接下来将要使用的模型(提示词格式正确,且可以根据自己的想法进行图生图)

警告:

在本地部署使用过程中请时刻关注你得GPU/硬盘等硬件状态,并在必要的时候强行停止AI生成以防止您的GPU/其他设备损坏。

本文档内容完全公开、免费,InvokeAI为开源软件。如发现有人售卖此文档或此文档的部分内容、售卖Invoke安装包/整合包或所谓“破解版”,请立即退款并举报商家。

文档基于公开材料和经验编写,作者不对内容准确性负责。

另外因您的数据的产生、收集、处理、使用等任何相关事项存在违反法律法规等情况而造成的全部结果及责任均由您自行承担。

前言:

图生图时常被轻视,有人觉得不稳定,有人觉得效果差,还有人觉得它难以控制,不像正统文生图那样确定,因此有兴趣的人愈少,使用者更是寥寥。

然而重绘学派的实际价值却并不低,相反,它还能做到更多单纯文生图做不到的事情。借助图生图,可以在AI随机的海洋中强行撞出一条路来,能化不可能为可能。重绘,实际上就是借助更多的输入、借助对输入图片预先的修改、借助在AI生成过程中的人工干预,达到一种介乎人与机器之间的效果,使其逐渐倾向于能够精准控制,这是图生图的本质,而重绘学的终极——其实是手绘。想象你可以具体到单独控制每一个像素点,这不就是人工绘画吗?

不过重绘毕竟是介于两者之间的,不是人人都有绘画的天分,但人人都有的基本智能——光这就已经超出了机器太多。只要将其赋予一部分给AI,给它一把推力,人机协同便能产生1+1>2的效果。

本文将分为三个部分,分别从工具、应用、研究三部分讲述重绘学派的基础,其中工具部分不讲具体运用,只讨论使用方法;应用部分以课题的方式展开,通过几个具体案例,提供几种用法的参考;研究部分是一些对于重绘法术中不明晰的地方的探讨。如果仅仅希望了解如何使用,那么可以只读前两章;如果希望灵活使用,则不要局限于第二章的用法,应该将各种材料有机的结合,开发自己的用法。若有问题,可查阅研究部分-常见错误一节。重绘学派法术变化万千,恕本文不能一一包含。

落辰星2023年7月1日

工具部分

1. invokeAI:工欲善其事必先利其器

1.1. InvokeAI

invoke是一个线上可用,带有本地部署UI的开源软件,线上使用需要付费且很贵。本地部署则需要使用自己的显卡,推荐使用RTX4090。

本地UI链接:https://github.com/invoke-ai/InvokeAI

● 硬件需求

说明:最低推荐配置的意思是配置低于这个就完全不建议入坑AI绘画了,如果强行想要使用,有些也是没问题的,但是还是建议硬件水平低于最低推荐配置时更换为更为强劲的硬件。当然使用云端部署也是没问题的(纯新人建议使用windows server)

● 软件需求

Linux:用Linux当主力系统的还用我教?

Windows:最低要求为Windows 10 64比特,请确保系统已更新至最新版本。windows7就不要想了,建议直接升级到win10/win11

macOS:没用过,不会

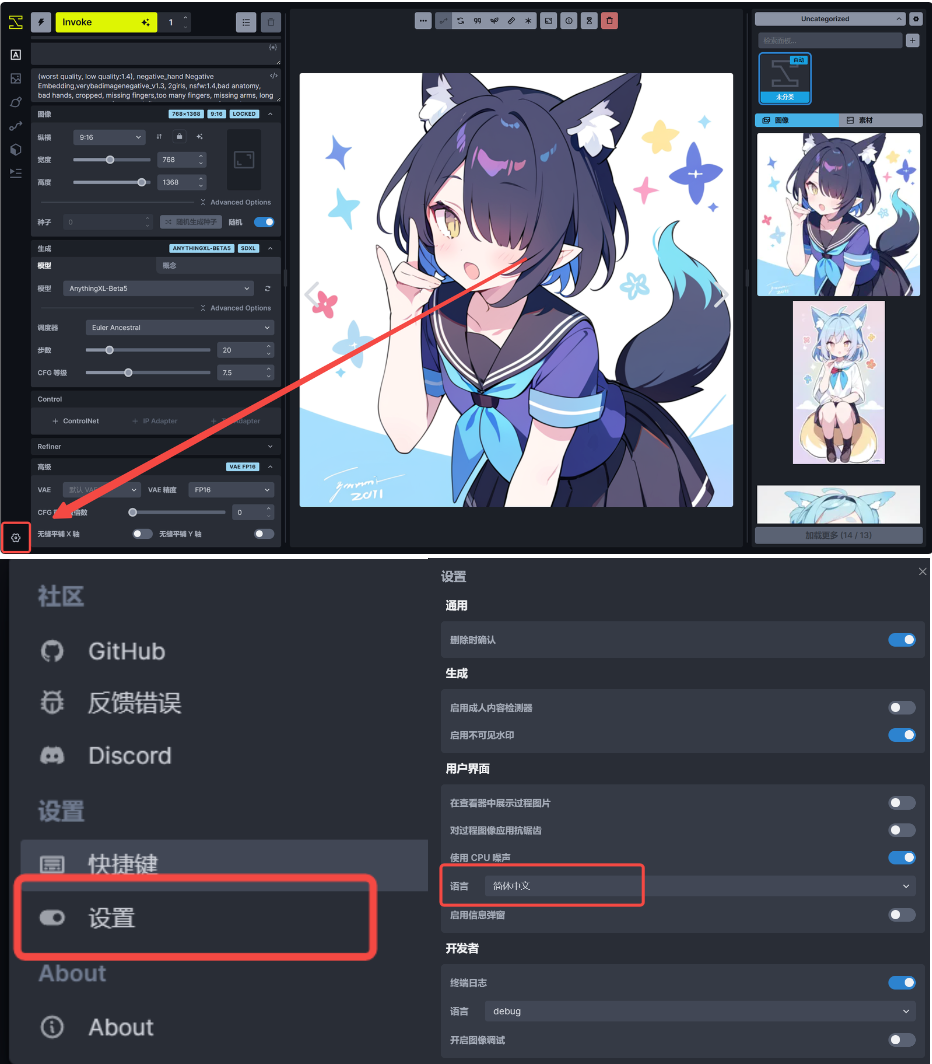

当然,你部署好Invoke的第一步,大概率是想要调成中文:(在这里调)

1.2. 推荐模型

SDAS Prem:https://tusiart.com/models/697051880532204841

ANYT Simpler:https://tusiart.com/models/647970544756545190

暂时不推荐使用别的模型,暂时不推荐使用SDXL的模型

2.文生图:有总比没有强

传统的文生图,如果你学习过AI绘画,那么应该会非常熟练的调整这些参数。虽然这里的图生图可以调整的东西,以及相关的插件或者其他,都不如使用Webui,但是也够用了,没必要单独再开一个webui来处理文生图

3.图生图:最简单的重绘工具

图生图是最简单的重绘工具,讲解将从这里开始,首先,我们来看看图生图的界面:

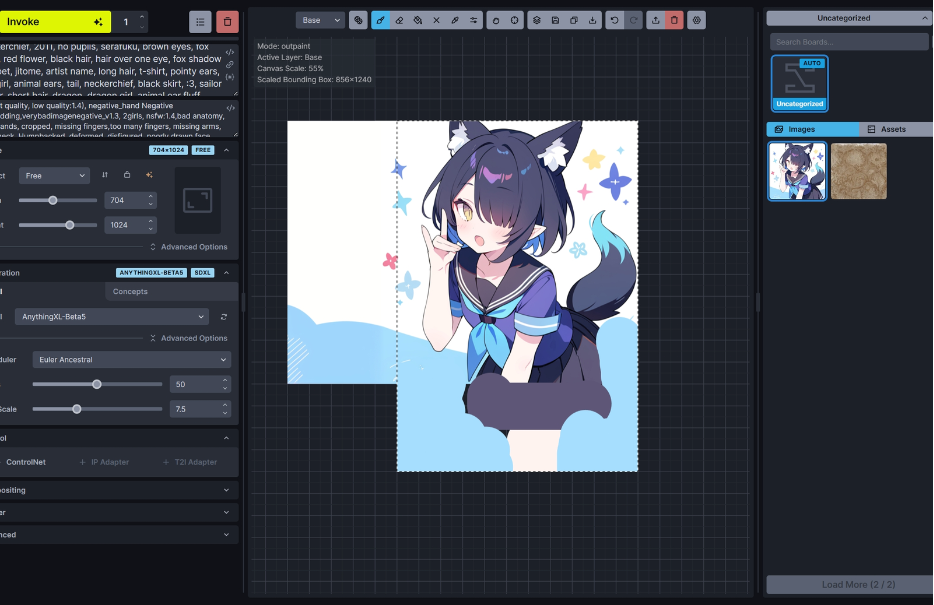

界面中间的左侧是上传参考图的位置,支持直接拖入,也可以从右侧的历史记录里拖入,最左侧是生成的图片

①为生成尺寸设定,当拉动拉条时,参考图上会显示比例关系。

②为当参考图与设定尺寸不符合时的处理方法,仅调整大小就是拉伸,会改变比例;下方是为图生图的灵魂,重绘幅度设定,根据具体的需要,重绘度的变化较大,所以绝对值参考意义较小。应该看相对值,太过了减小,不足加大。0表示完全为原图,1表示完全为新图。经验上以0.5为区分:0.5以前都能保持原图大部分内容,反之则再创作更多。界面下方则是插件,与文生图一致,不多赘述。

③为生成的AI参数,分别可以更改模型,采样器,steps和CFG

4.统一画布:你的最强画笔在这里

4.1. 选择框

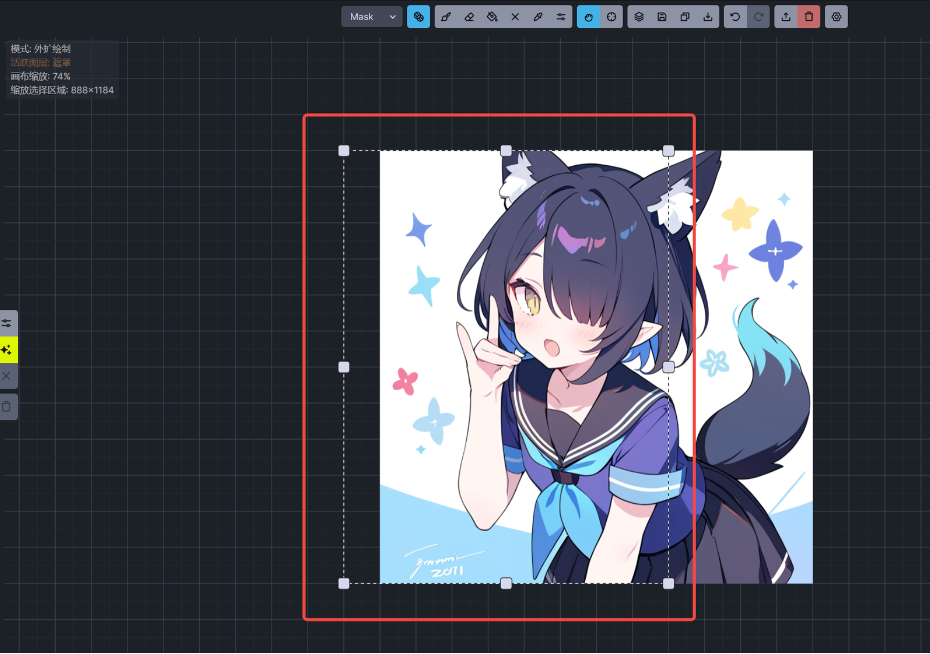

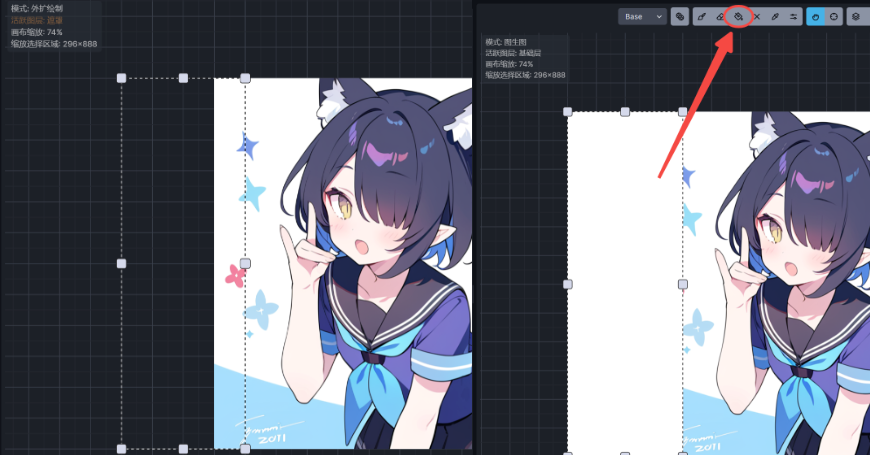

选择框是一切的基础,任何模式的范围都是以选择框为依据,进行AI处理的时候,只会对选择框内的部分进行处理。画布分别有:局部重绘、图生图、外扩重绘、文生图等功能

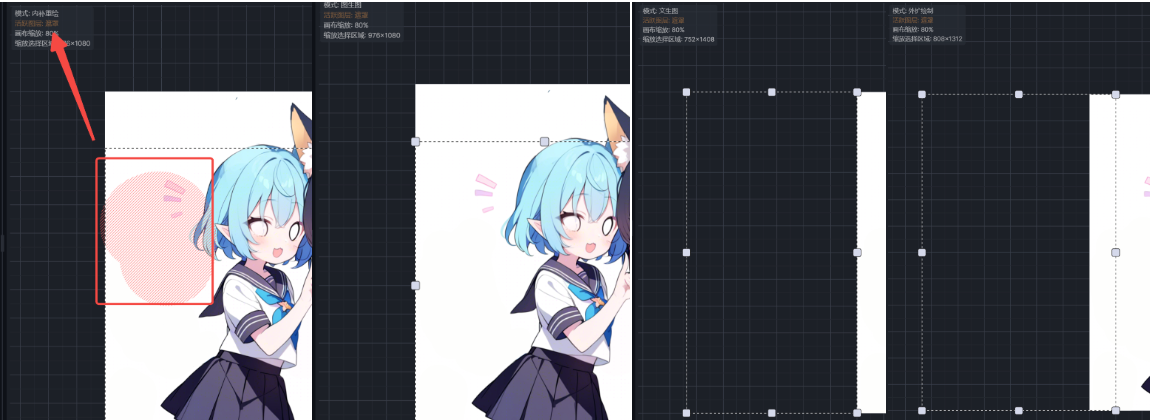

而根据选择框的不同,有4种不同的模式,这4种不同的模式均为自动切换,你只需要注意选择框的位置即可:

当选择框完全在已经存在的图内并且涂有蒙版时,则是局部重绘模式;当选择框完全在已经存在的图内并且没涂蒙版的时候,则是图生图模式;当选择框完全在已有图的外面时,则是文生图;当选择框一半在已有图内一半在外面时,则是外扩重绘。

4.2. 工具区

看图基本就知道是干嘛的,下面的顺序是从左到右

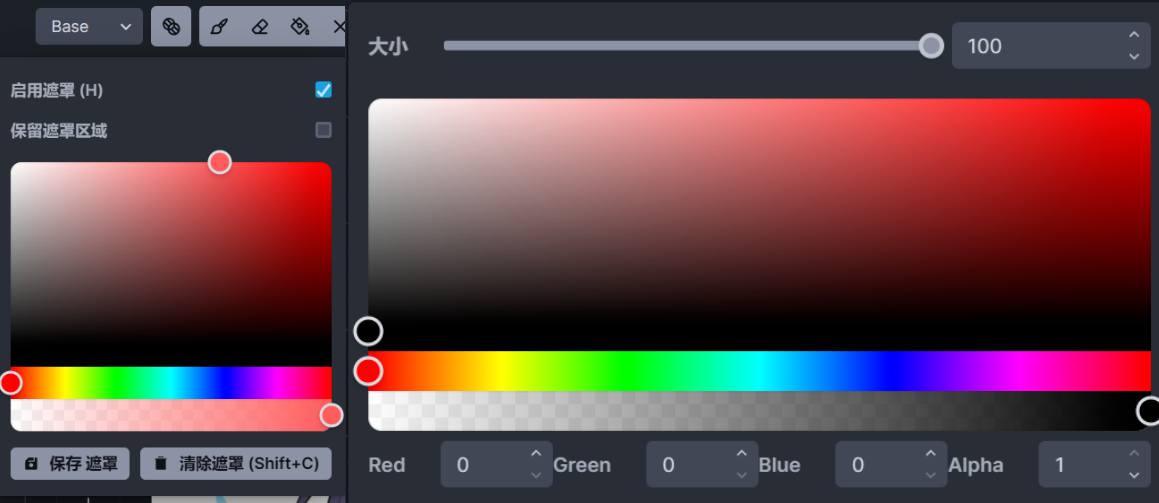

左侧:蒙版/画笔切换、蒙版选项、画笔、橡皮、颜料桶、删除区域、吸色管、画笔调节。

中间:选择拖动,和重置视图。

右边是合并图层、保存至右侧快捷栏、复制到剪贴板、下载、撤销/重做、上传图片、删除图片、设置

两个二级菜单分别如上图可见。分别是蒙版选项和画笔选项。

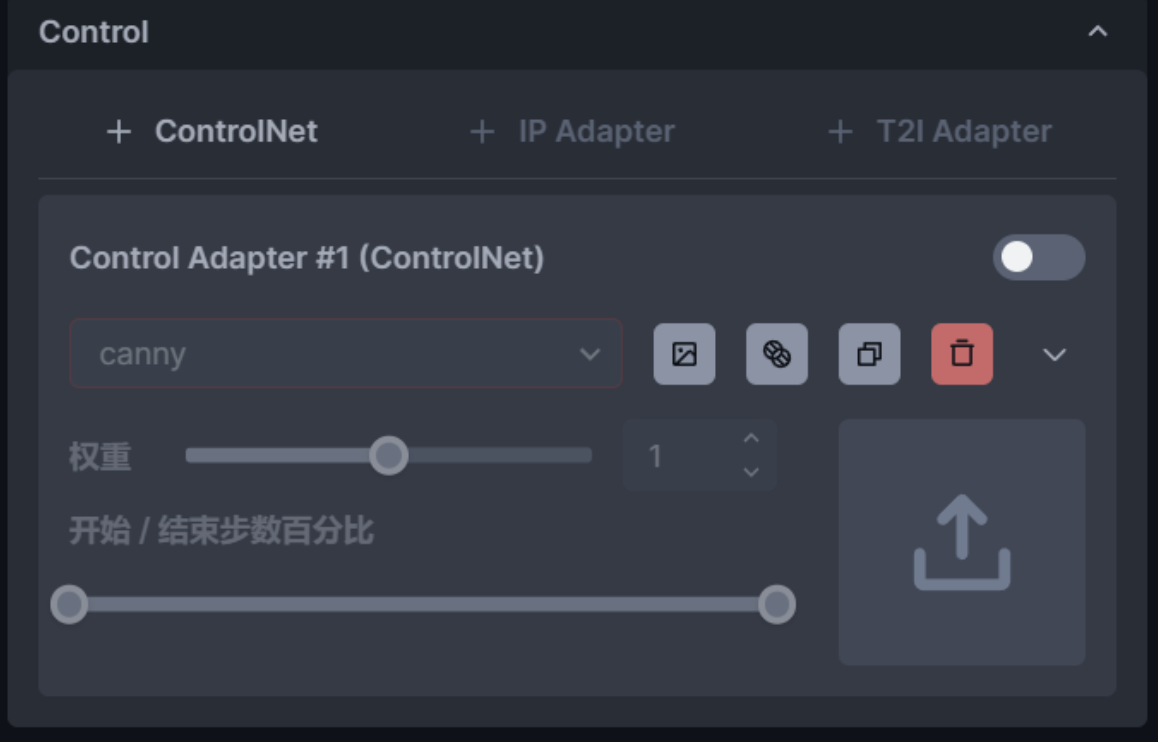

4.3. Countrol

Controlnet本质是提供额外的参数以施加多维控制,所有的controlnet模型都需要参考图,可以看作一类特殊的图生图。ControlNet使用需要下载专用的ControlNet模型,并且许多模型在SDXL中效果并不好用。模型是可选的,无需一股脑的全下了,看清楚自己需要什么模型,用的时候临时下也不迟。

另外invoke也提供了IPAdapter和T2IAdapter使用:

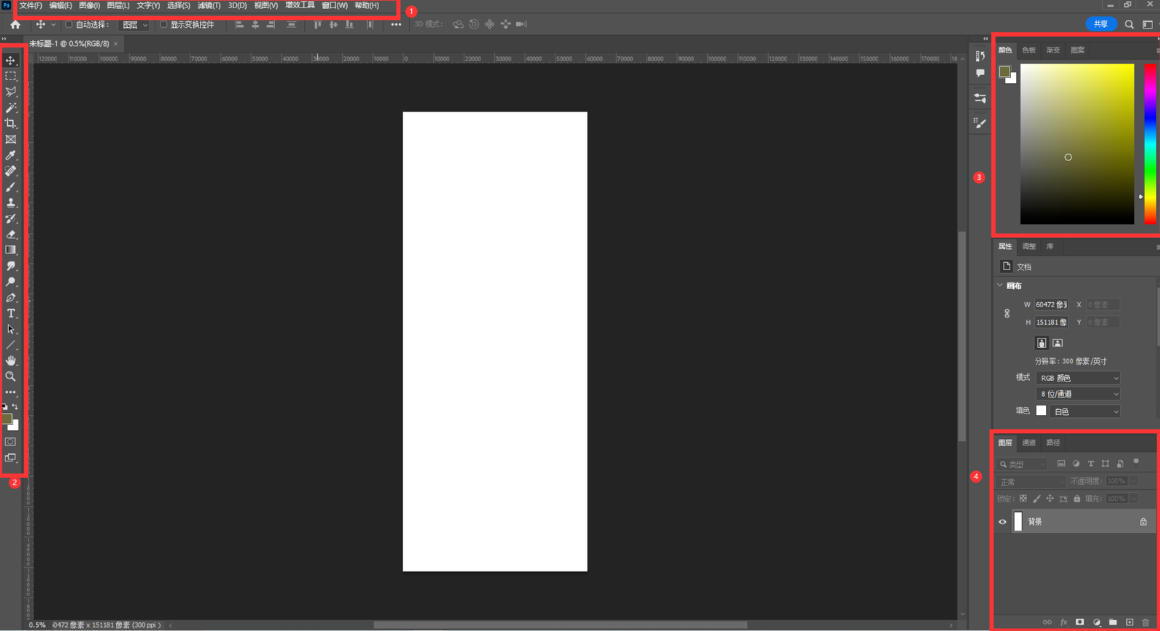

4.4. Photoshop

这里虽然说不需要跟Webui中实现部分操作一样硬性需求PS。但是按照惯例这里提一下:这里以本机装的2022版为例,说明一些基础的不能再基础的操作。

①为菜单栏,你可以在这里找到各种操作,如果你看不到某些工作区,布局也是在这里设置。

②为快捷工具栏,需要用到的大部分工具都在这里选择,然后再到图上涂抹。

③为调色盘区域。

④为图层工作区,添加图层添加蒙版都在这里。

应用举例

1.图生图基本理论

在开始本章之前,需要说几个常识,也是图生图修图的基础。本章中各种方法,根本思想都起源于下面的简单事实。当然,很多人早就知道了,也可以直接略过。

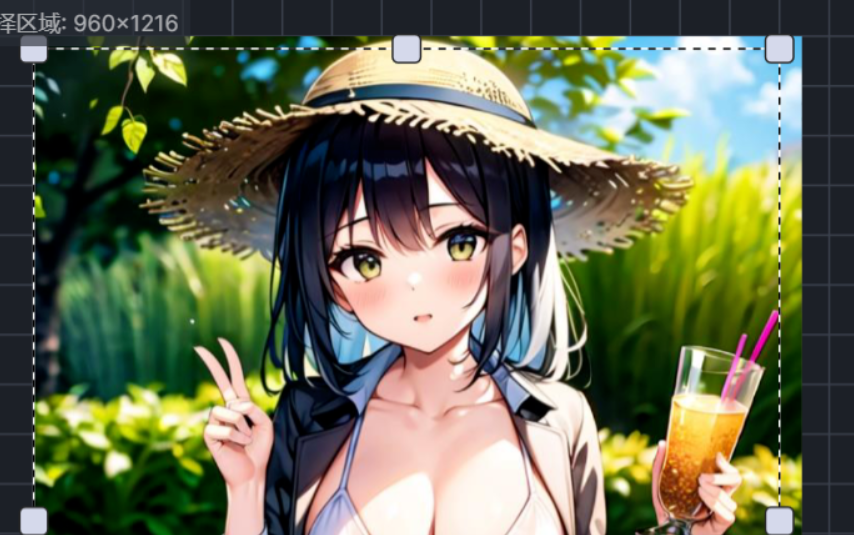

SD模型对于画面占比越大的事物越容易画好,反之占比越小就越画不好,举个例子,中远景人物崩脸的概率显著高于特写,另一个例子是,以画不好手出名的AI,在强调手的tag下,例如beckoning之类,出好手的概率顿时暴增,这是由扩散模型本身的性质决定的,而我们可以顺应这种特性。例如,将手部裁剪下来,这不就是一张手部特写图了吗?再请AI重绘,抽卡难度瞬间下降。同理,AI画大的事物清晰,小的不清晰,同样将小的物品转化为大物品经过重绘再放回原图,就可以保证处处清晰。

1.图生图也是需要提示词的,虽然在多维度约束下,提示词对于AI的参考意义一定程度上被削弱,但这仍然是参考的主要成分。提示词可以反推,但相比反推模型,一定是你的眼睛分辨更加精准,只有传递给模型正确的指引——至少不要和重绘内容打架,才能抽卡出好的结果。图生图使用的提示词应该是希望AI画成的内容,比如说,图生图更换风格,那么你就需要描述画面中不希望改动的内容,并且加上风格词,甚至还需要加权;再比方说,将车局部重绘成马,那么你的提示词就应该是有关马的详细描述;最好,当你发现局部重绘的对象丧失了与全图的关联,那么你还需要适当描述一点蒙版以外的内容,便于模型理解。

2.图生图修图的本质是施加多维约束。试想,当你写上提示词生图的时候、当你涂上蒙版重绘的时候,你究竟告诉了AI多少信息?这些信息能够唯一的锁定你要的东西吗?显然不是的,一个很简单的道理,如果你不告诉画师更具体的要求,那么他就只能猜来猜去,当你所给信息较少,那么实际上只是在挤眉弄眼的暗示,怎么可能一发命中呢。所以越强的约束操控者的自主性越强,相应的,AI的发散性就越差。如果你不满AI的天马行空了,那就应该有色蒙版/PS/controlnet结合着灵魂画技给它比划,总好过使眼色对吧。

3.图生图需要将原图反推为潜空间数据,因此占用会比文生图更高,并且参考图尺寸越大占用越高。对于局部重绘,占用会比单纯图生图再略高,但这并不意味着低显存就不能局部重绘,实际上Invoke只会将选取框内的内容裁剪下来重绘。另外由于图生图会经过两次VAE,在使用VAE异常的模型时,每次重绘都会导致画面变得更灰。

4.图生图的模型选择要符合参考图画风,或者至少接近、不矛盾。例如你不能用SD1.5原模来重绘一张纸片人图。但不代表就必须要一模一样,相反用截然不同的模型来出图和重绘,偶尔还能做出风格交融的效果。

5.用图生图的方法应该具有一种阶段性的思想,即:不强求一次成图,可以分别抽出好的背景、好的人物、好的构图、好的姿势,通过图生图将它们有机结合在一起。而且也并非只能出全图,比如可以让AI产生某些素材,用来贴进画面。最后,实际上模型的能力也是有限的。当模型中根本就没有相关数据,那么这就是不可能画出来的,比如某些特殊视角、构图。那么此时,就只有通过手中的笔了。

2.修手:对AI任何不满意的地方都可以通过AI解决

本章第一个案例是修手,毕竟,SD画不好手是老生常谈的问题,好不容易出了一张满 意的图却坏了手,这也是常见的事。

如法炮制,另一边也修好了

3.添加元素:你可以随意的控制这个世界

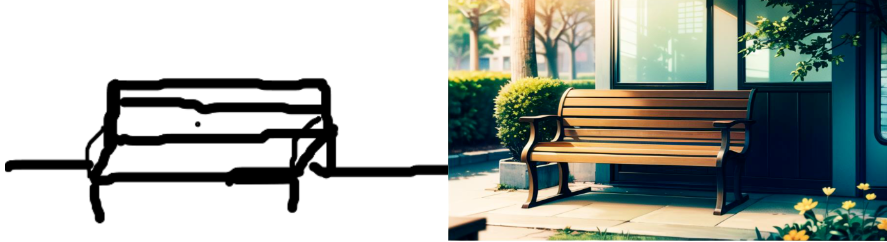

本课题中,我们将从背景图开始,通过逐渐添加元素完成一张图。首先,用ControlNet的涂鸦模型通过灵魂画技随便整张背景。

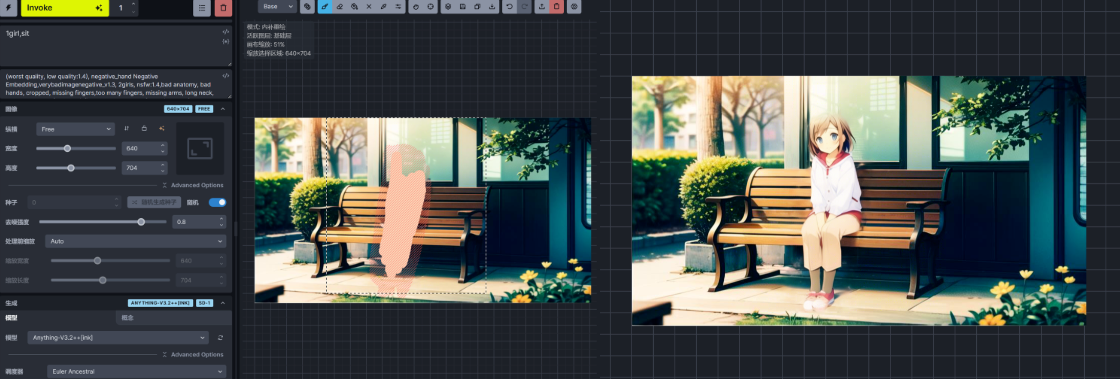

然后我们就可以涂一块区域进行生图(当然,灵魂画手稍微画一下效果比这更好,涂色块纯粹是因为我懒),当然你还可以进行其他操作,比如加个广告牌加个鸟等,总是这些都是相当简单的。

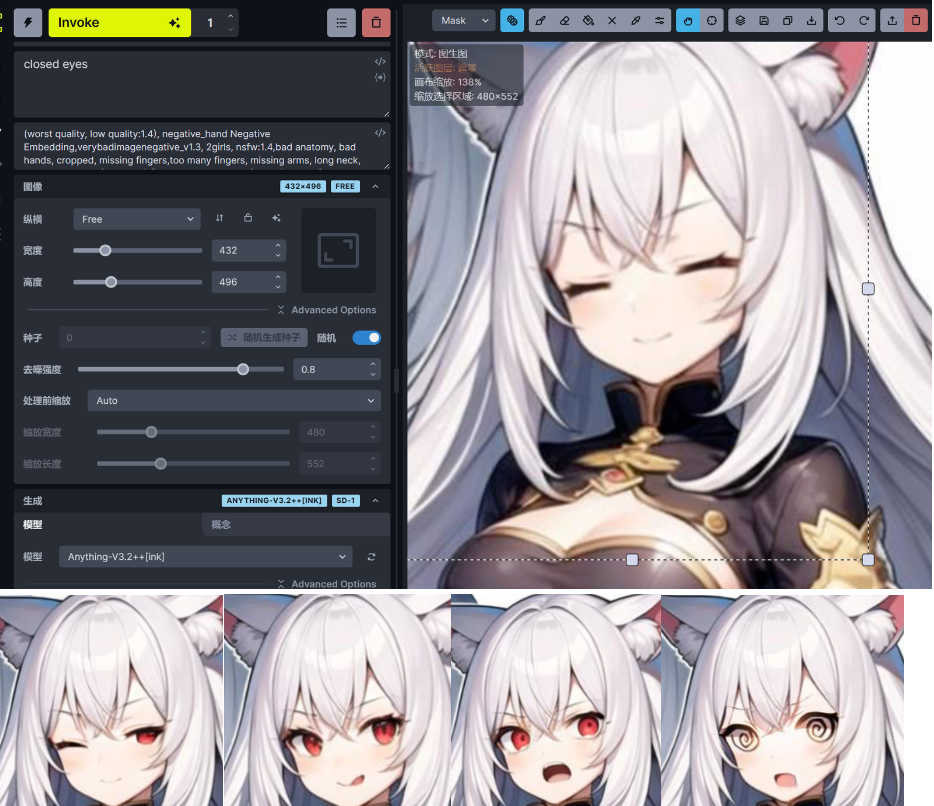

4.差分:任何事物随意更换

也是灵魂画手即可,略微画一下我想要的表情,并且输入提示词,然后选框+蒙版直接生图即可:

5. 更改画风:你的烂模型拯救助手

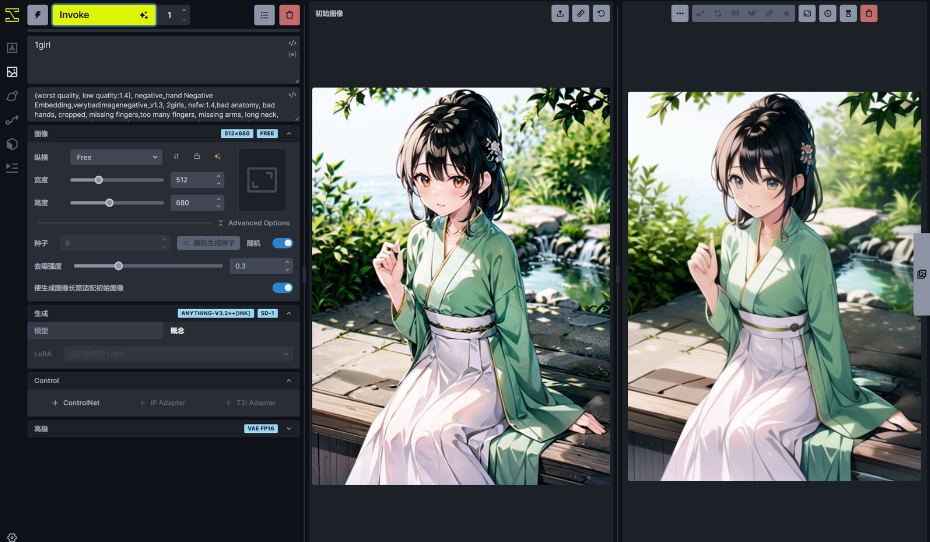

简单换个模型,然后低去噪强度图生图就可以用了,甚至都不需要统一画布

6.LoRA协同:1+1当然可以等于2

先来看原始图,这是两个LoRa的效果,这两个lora同时调用会发生什么我想不用多说。

那么步骤的开始,是先跑一张合适的底图,先单独调用左图lora,使用合适的动作 tag,得到下图左,然后再画右图LoRA的角色,生图就大功告成了。 可见思路就是跑出合适构图的雏形,再将具体所要的人物通过局部重绘加入画面中。

7.画多人:超高的可控性,超高的上限

无论是SD1.5还是SDXL,画多人图都是很困难的,更别提我还想要指定的特征。但是在图生图里,一切都是相当简单的:

跟LoRA协同一样,我们可以先画左侧的人物(甚至可以直接文生图),然后再利用图生图画上右侧的人物。

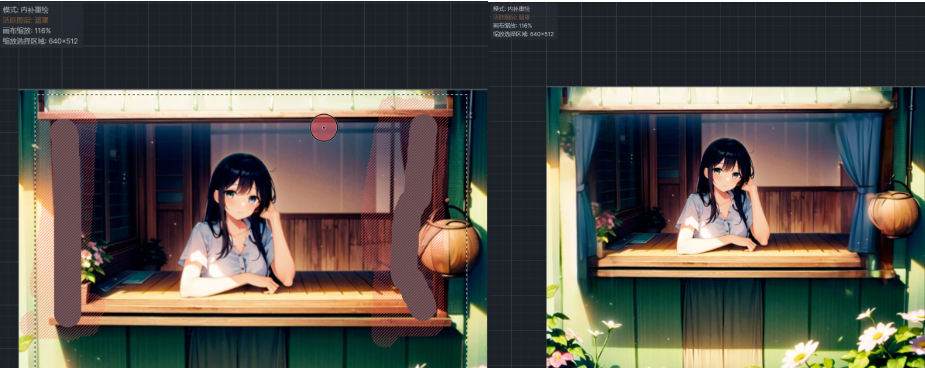

这里需要注意一个点:画多人的时候,如果是进入了外扩绘制模式,那么效果是很差的。这时候我们就需要点一下油漆桶,先涂满色块,然后再从色块上绘画(这时候可以使用蒙版重绘),这样效果才是好的。

8.远景图/全身图:你想要的都能画

首先原图是这个:这个原图上面已经出现过了

远景你可以使用外扩重绘(简单色块涂鸦即可),下图是外扩了一部分,并且涂鸦了下半身的内容:

点击生图,生成如下图所示的图。我们可以利用这个功能一点一点的实现扩大画布(远景大图)、画出全身等效果

9.命题作文:谁都可以妙手生花

本课题将综合运用各种图生图功能,以达到目的为准,不拘一格,可谓是命题作文, 题材不限。那么先说命题,一个坐在窗边望着窗外的少女,视角是从窗外看的。

首先灵魂画手,先简单涂鸦出我想要的内容:

其次,拖入ControlNet使用涂鸦模型,生成大概下面这种图(左图),然后反复进行图生图增加一些细节(右图)。

房间内确实细化了一些,但有个问题是,它把我要的窗帘吞掉了。这个时候画上去就行(简单灵魂画手涂鸦即可,提示词记得改成窗帘,不然不容易出图),点击生成即可。

研究部分

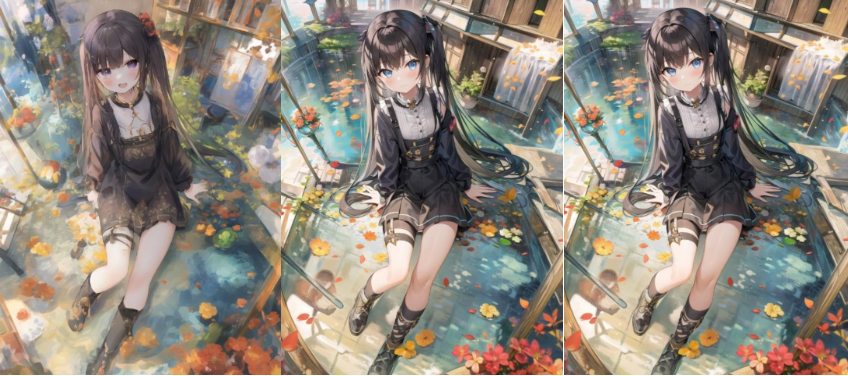

1.图生图是难以复刻但并非完全无法复刻

如下所示,进行了两次同参数图生图(右2图),固定种子,可见,图生图和文生图一样是可以稳定复现的。

但通常情况下,即使拿到别人图生图的原图,图里并不会存储参考原图、重绘度,蒙版 处理方式等信息,参数不足无法保持一致,局部重绘更是几乎无法复刻,因为蒙版为手画, 不可能完全一致,这都是导致图生图难以复刻的原因。但这不代表图生图是完全无法复刻的 随机黑箱!图生图与文生图一样,确定的参数产生确定的结果

2.高清修复与图生图的关系

有人注意到,在以前的WebUI的图生图中没有高清修复(现在有没有不是很清楚),这是因为高清修复本身就是图生图。来看一 组对比,我们固定包括种子在内的参数,先生成一张小图,再同种子高清修复,再用此前的小图进行图生图放大(保持放大算法与高清修复一致),左侧为原图,右侧为两次放大的效果:

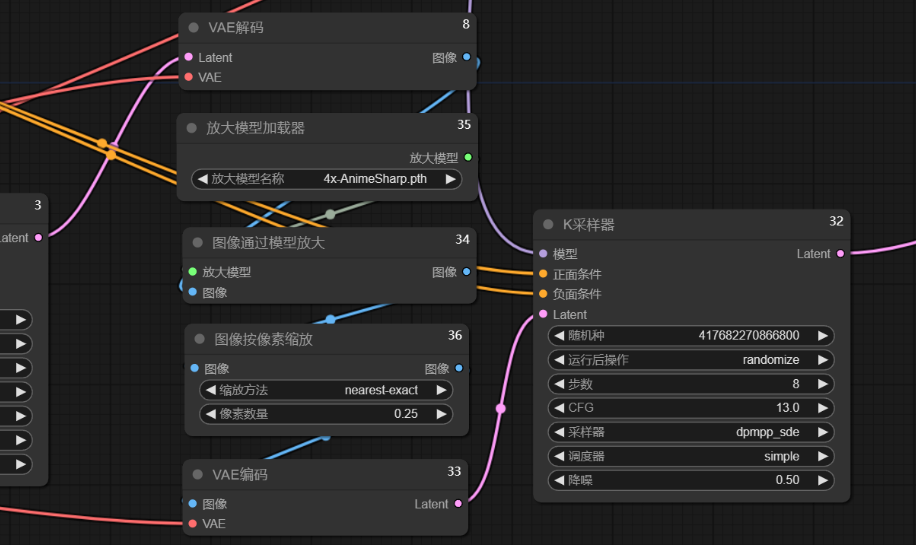

你玩过Comfy那就更好解释了:玩过的话应该会知道非潜空间的高清修复应该是怎么连的