The LoRa was trained on just two single transformer blocks with a rank of 32, which allows for such a small file size to be achieved without any loss of quality.

Since the LoRa is applied to only two blocks, it is less prone to bleeding effects. Many thanks to 42Lux for their support.

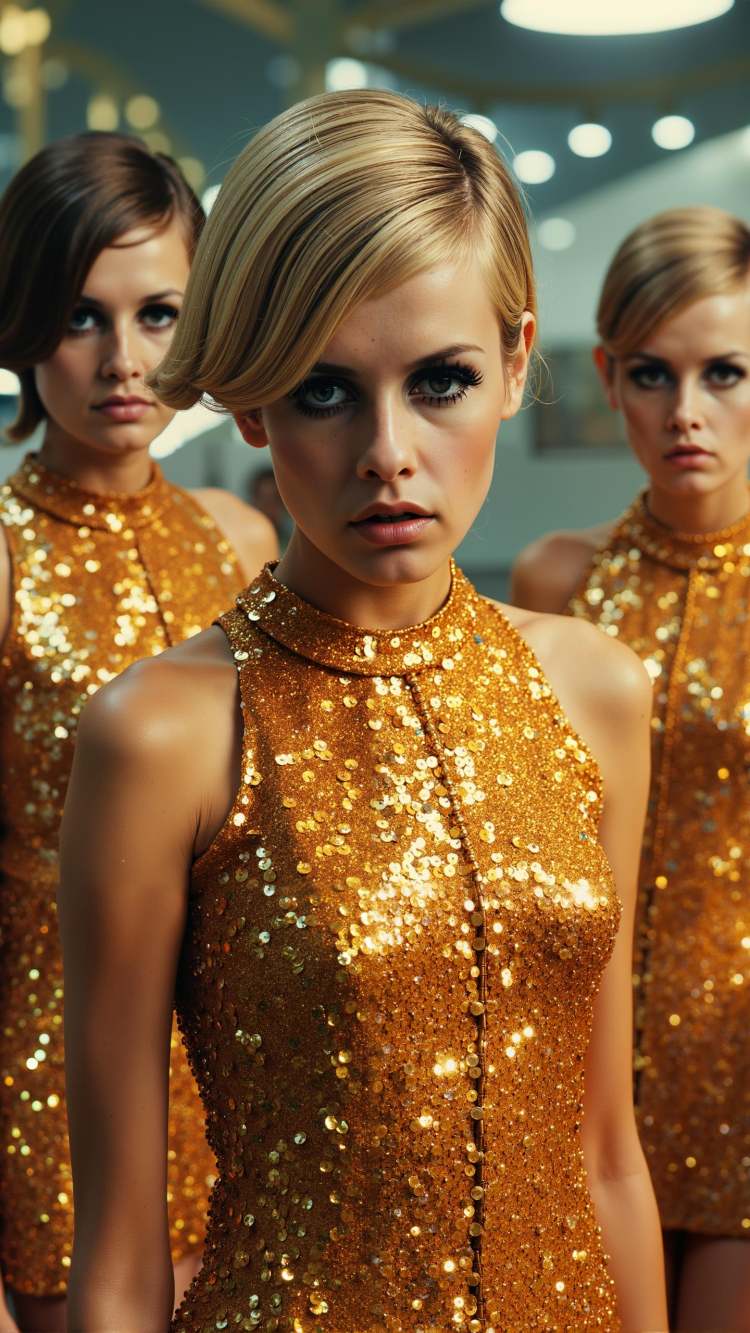

Twiggy [2.3MB Single Transformer Flux LoRa]

LORA

版本详情

基础模型 F.1

项目权限

在吐司在线使用

在 吐司 作为在线训练的底模

使用时无需注明出处

用于模型融合

分享融合模型时使用不同的许可

使用权限

生成的内容用于商业用途

作为生成服务来商用

转售模型或出售融合模型

商用许可

相关帖子

描述想生成的画面,回车发送